L'IA générative peut augmenter le PIB suisse de 85 milliards par an d'ici 2034

C'est ce que montre, entre autres, une étude d'Implement Consulting sur l'avenir économique et la préparation à l'IA en Suisse.

Un avenir digital pour la Suisse.

Avec une vision à long terme. De manière responsable. À Zurich.

6 milliards

de valeur ajoutée brute seront générés en Suisse en 2023 par l'utilisation des services de Google.

EIR 2023

> 100 start-ups

ont été créées par d'anciens collaborateurs de Google, ce qui a permis de créer 1 700 emplois.

Internal

> 5’000

Googlers de 85 nations travaillent sur des services comme Gemini, Search et YouTube.

Internal

+11 %

l'intelligence artificielle générative peut augmenter le PIB suisse annuellement d'ici 2034.

Internal

C'est ce que montre, entre autres, une étude d'Implement Consulting sur l'avenir économique et la préparation à l'IA en Suisse.

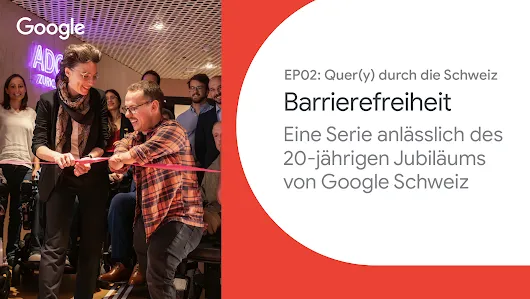

Regarder la vidéo

Link to Youtube Video (visible only when JS is disabled)